반응형

이전에 Route53 에서 TXT 레코드를 추가하고 robots.txt 파일의 내용을 집어 넣었던 기억이 있다.

키워드만 정리해 놓았었는데, 뭔지 궁금해서 정리해본다.

정의

"robots.txt" 파일은 웹사이트 소유자가 검색 엔진 로봇(또는 크롤러)에게 자신의 웹사이트의 어떤 부분을 크롤링하고 색인화할 수 있는지 제어하기 위한 표준 프로토콜입니다. 이 파일은 웹사이트의 루트 디렉터리에 위치하며, 검색 엔진 크롤러가 웹사이트를 방문할 때 이 파일을 확인하고 그에 따라 행동합니다.

왜 사용하는가?

- 크롤링 대상 제어 :

- 웹 사이트 소유자는 어떤 검색 엔진 크롤러가 그들의 웹 사이트를 크롤링할 수 있는지 제어하려는 경우 사용한다.

- 이를 통해 웹 페이지의 특정 부분을 숨기거나 숨기지 않고 검색 엔진에서 색인화할 수 있다.

- 검색 엔진 최적화 (SEO) :

- 웹 사이트에는 일부 비공개 정보가 포함된 디렉터리나 파일이 있을 수 있다.

- 이러한 비공개 정보에 대한 액세스를 검색 엔진 크롤러로부터 제한할 수 있다.

- 크롤러 부하 관리 :

- Crawl-Delay 지시어를 이용해 크롤링 속도를 조절해 웹 서버의 부하를 분산시킬 수 있다.

- 테스트 및 개발 환경 :

- 웹 사이트의 테스트 또는 개발 환경에서 사용하여 검색 엔진 크롤러가 이러한 환경을 크롤링하지 않도록 할 수 있다.

- 비공개 정보 보호 :

- 민감한 데이터가 포함된 페이지 또는 디렉터리를 숨기는 경우 액세스를 거부할 수 있다.

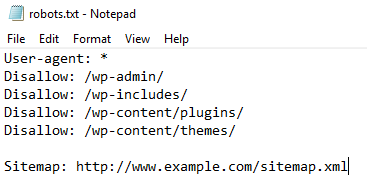

구조

User-agent: Googlebot

Disallow: /private/

Allow: /public/

Crawl-Delay: 10

User-agent: Bingbot

Disallow: /admin/

- User-agent:

- 크롤러 또는 로봇의 이름 또는 식별자를 나타낸다.

- 여기에 나열된 크롤러들에 대한 규칙을 정의할 수 있다. 예를 들어

User-agent: Googlebot은 Google 검색 엔진 크롤러에 대한 규칙을 지정하는 것을 의미한다. - 애스터리스크로 모든 agent에 대해 규칙을 설정할 수 있다.

- Disallow :

- 크롤러에게 특정 디렉터리 또는 파일에 대한 액세스를 거부하는 규칙을 정의한다.

- /private/는 "private" 디렉터리를 나타내고 크롤러는 해당 디렉터리에 접근할 수 없다.

- Allow :

- 크롤러에게 Disallow 규칙에 예외를 추가하는 데 사용된다. Disallow보다 Allow가 우선시되며, 특정 경로를 크롤러에게 허용할 때 유용하다.

- Crawl-Delay :

- 크롤링 사이의 딜레이를 설정한다.

- 이를 통해 웹 서버에 과도한 부하를 주지 않고 크롤링 속도를 제어할 수 있다. 값은 초 단위로 지정된다.

내 생각

음 왜 사용하는 지 정확히 몰랐었는데 결국 크롤러에 대한 내 웹사이트의 제어를 하기 위해 사용하는 것같다.

[참조] :

ChatGPT

https://www.vdigitalservices.com/how-to-use-robots-txt-to-allow-or-disallow-everything/

반응형

'CS 지식' 카테고리의 다른 글

| 사일로(silo)란? (0) | 2023.11.13 |

|---|---|

| DNS 플러쉬(Flush)란? (0) | 2023.11.09 |

| Kafka란? (2) | 2023.09.30 |

| 서킷 브레이커(Circuit Breaker)란? (0) | 2023.09.25 |

| 컴퓨터 구조란? (0) | 2023.08.09 |